小米最新推出的开源推理模型令人惊喜,因为它竟然能在手机上流畅运行,这一创新技术的出现,打破了传统推理模型只能在高性能设备上运行的限制,使得更多普通用户也能享受到高效的推理服务,这一突破性的技术进展,预示着未来手机智能应用的广阔前景。

说到语言模型的本地部署,许多人首先想到的可能是高昂的成本和高端的显卡,就像世超那台嗡嗡作响的老电脑,打LOL都费劲,可以说就是这台老古董阻碍了我们体验AI。

有没有不需要高配设备、不吃配置的方法,让我们普通人也能感受到本地部署AI的快感呢?答案是肯定的。

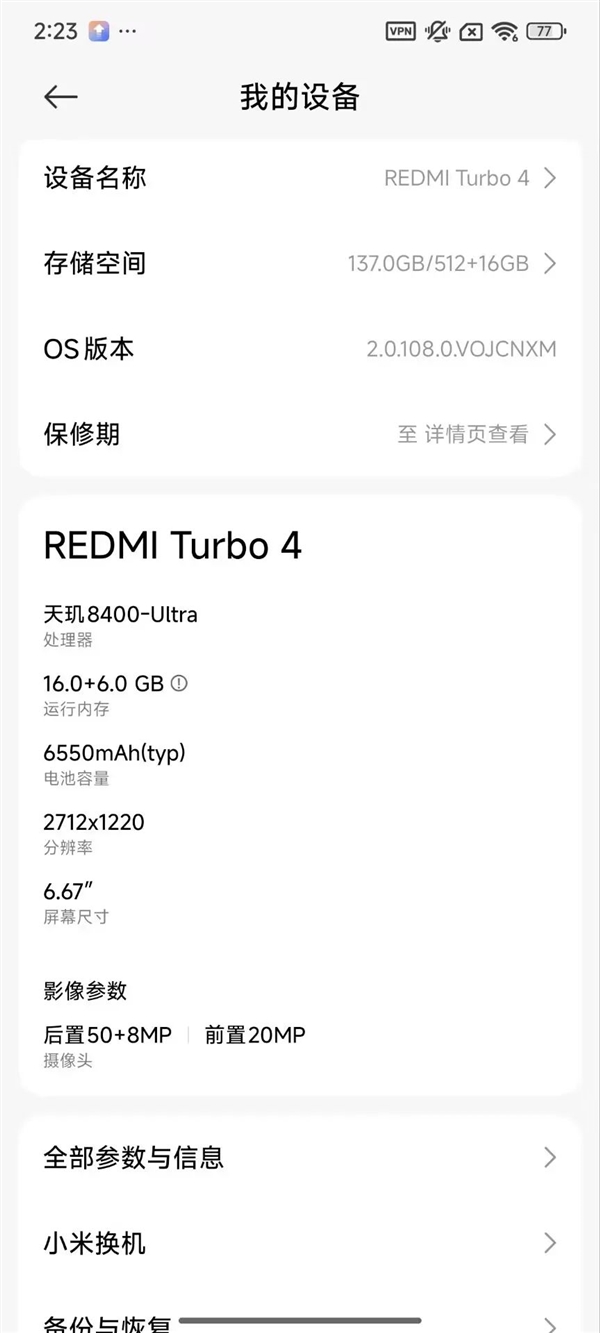

世超这台不到2000元的红米Turbo4手机,居然能成功部署小米最新的语言模型Mimo-7B量化版,在完全断网的情况下,它也能一字一句地输出正确的结果。

众所周知,世超一直想着让普通用户也能体验到AI的魅力,因此他带来了保姆级的部署教程,包含两种方法。

第一种方法,是下载Pocketpal AI这款应用程序,专为手机跑AI模型而设计,然后按照应用内的指引,轻松下载并部署Mimo模型,之所以推荐这种方式,是因为它足够简单易懂,即使是不懂技术的人也能轻松上手。

第二种方法,是在浏览器上访问特定的网址,这是一个由阿里开发的端侧多模态模型部署平台,你可以随意挑选并下载你想体验的本地模型,甚至还能运行Stable Diffusion。

部署完成后,我们来测试一下效果,世超有一天在亚马逊的热带雨林迷路了,手机一格信号都没有,他立刻掏出手机,用Mimo询问如何钻木取火,不到三分钟,Mimo就给出了详细的答案,这就是小型模型的独特优势——无视环境,随时随地运行。

不仅如此,这些小型模型还能在手机等移动设备上轻松运行,这意味着无论你在雪山、沙漠、海洋还是外太空,都能随时随地的使用你的私人助理,如果模型再小一点呢?阿里最近发布的Qwen3模型,参数只有0.6B,在MNN平台上也能轻松运行,虽然输出的语句有些深奥,但这并不影响它的实用性。

有些人可能会说,你这是异想天开,但小型模型的用处远不止于此,如果说AI要想更贴近我们的生活,还真得靠这些小型模型,它们不仅可以随时随地为我们提供便利,还具有低延迟的优点,参数少意味着思考和决策的速度更快,完全遵照主人的命令,参数量越小,训练和部署的成本也就越低,很多小公司都在利用小型模型进行垂直领域的训练和应用,这些模型不仅可以用于聊天等日常场景,还可以成为金融、医疗等领域的专业工具,现在有很多专业型模型已经在各自领域展现出强大的能力,例如度小满的金融模型XuanYuan-6B在注册会计师等多项金融领域考试中都能表现出金融领域专家的水平,同时许多公司也在小型模型上全面发力利用一些新奇的算法将小型模型的性能提升到极致甚至能与大型模型相媲美,像DeepSeek-R1-Distill的7B和14B版本在数学推理任务上就能超越很多大型模型闭源大模型也不例外,还有一家专门做端侧模型的面壁智能公司他们推出的MiniCPM只有8B但表现却能媲美GPT-4o而且他们还成功地将多模态能力融入了小型模型中实现了全模态端到端的体验就连苹果也开始自研小型模型他们的AFM-on-device在文本总结任务中效果卓越甚至超过了更大参数的模型那么问题又来了这些模型参数这么少又能赶上大模型这凭什么呢其实这些小模型都有独门秘籍比如知识蒸馏就像让老师给学生开小灶让大模型把知识和经验传授给更小的模型还有剪枝量化等方法可以在不需要很高精度的情况下把模型里的高精度计算变成低精度计算让模型跑得更快去年英伟达联合Meta发布的Llama-3.1-Minitron 4B AI 模型就是从原本的8B模型剪枝而来还有混合专家模型MoE架构的作用就是把专家拆分成专业小组遇到小问题就不需要全员加班了因此别看这些模型个头小说不定就是迈向AI世界的又一大步就像科技进步从不是一蹴而就的让我们一起静待花开结果吧。